Wir schreiben zwar gerade erst das Jahr 2024, jedoch gibt es bereits heute einen ziemlich klaren Ausblick darauf, in welche Richtung sich Rechner zur Videobearbeitung in den nächsten 24 Monaten entwickeln werden. Beziehungsweise, weshalb die Videobearbeitung in der Cloud wahrscheinlich schon bald die Norm sein wird.

Investment-Motor Künstliche Intelligenz

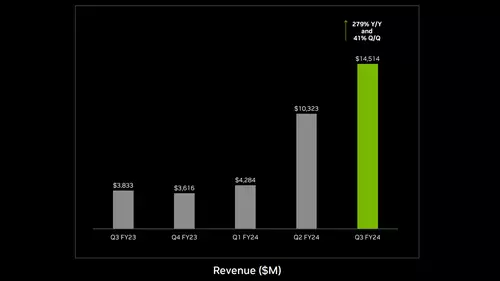

Größter Motor hinter der kommenden Entwicklung ist ein weiteres mal die Künstliche Intelligenz (KI): Wer sich hier in den letzten Monaten etwas mit den technischen und finanziellen Hintergründen der großen KI-Unternehmen befasst hat, weiß, dass diese in den nächsten Jahren dreistellige Milliardenbeträge in den Ausbau ihrer KI-Rechenzentren investieren wollen und sehr wahrscheinlich auch werden. Marktführer Nvidia will nach aktuellen Branchen-Schätzungen alleine schon in diesem Jahr (2024) sogenannte KI-Beschleuniger für mindestens 60 Milliarden Dollar ausliefern - und dies ist nur eine aktuelle Schätzung, die im Jahresverlauf erfahrungsgemäß noch einmal nach oben revidiert wird. Lisa Su (CEO von AMD) erwartet sogar, dass der Markt der KI-Beschleuniger bis 2027 auf ein Volumen von 400 Milliarden anwachsen wird! Das wäre das Fünffache des gesamten, weltweiten Servermarktes vom letzten Jahr!

Kurz gesagt: Für KI-Anwendungen wird in den nächsten Jahren eine Menge frische Rechenleistung installiert. Eine fast unvorstellbare Menge! Wer die technischen Hintergründe hierzu etwas verfolgt (oder aufmerksam slashCAM gelesen) hat, weiß, dass diese Rechenleistung nicht mehr wie in den letzten Jahrzehnten von CPUs, sondern vermehrt von GPUs erbracht wird. GPUs können universelle Programme nicht sonderlich gut ausführen, dafür aber gleiche Rechenschritte besonders effektiv "parallelisieren." Wenn man milliardenfach die gleichen Rechenschritte mit immer neuen Daten ausführen muss (wie beispielsweise bei Pixeln in einem Video), rechnen diese GPUs weitaus schneller und effizienter als CPUs.

Alles GPU oder was?

Mit dem "G" in GPU (Graphics Processing Unit) haben diese Beschleuniger eigentlich gar nichts mehr am Hut, sondern tragen ihren Namen nur noch deswegen, weil diese von den Grafikkarten-Chips abstammen, die ebensolche Berechnungen schon seit Jahrzehnten beschleunigen. In der KI werden diese GPUs dagegen heute für die Berechnung großer Vektoren genutzt, aber in Video-Applikationen wie Resolve oder Premiere beschleunigen sie auch nach wie vor die Pixelberechnung.

Nun sind die Rechenbeschleuniger in den KI-Rechenzentren zwar ein bisschen anders "zusammengeschaltet", aber im Grunde haben sie das meiste immer noch mit den klassischen GPUs gemeinsam. Das Wichtigste für den Hinterkopf ist dabei: Beide lassen sich von einem Programm nahezu identisch ansprechen. So kann ein großer Nvidia-Server mit 256 GPUs für eine Applikation genauso über CUDA angesprochen werden, wie eine einzelne GPU in einem Schnitt-PC. Ähnliches gilt auch (noch mit leichten Einschränkungen) für AMD GPUs.